近年、自動運転などの分野でLIDARが注目を集めている。日本コントロールシステムは、様々な3Dセンシングデバイスが利用可能な認識エンジン「GREEEN」をさらに拡張し、自動運転・無人化施工・搬送トレース等に適用可能な「360°オブジェクト認識システム GREEEN×LIDAR」を開発した。

1.開発の経緯

日本コントロールシステムは、1981年の設立当初より、製造現場で使用される外観検査装置など、画像処理技術をベースとしたマシンビジョン製品を多く手掛けてきた。

2000 年代前半になって、MESA 社や Canesta 社といった海外メーカからTOF(Time Of Flight)方式の距離画像センサが発表されるに至り、従来とは異なるアクティブな3Dセンシング方式の利点を活かしたアプリケーションが可能となった。

この動きを受け、日本コントロールシステムはこれまでのマシンビジョンに関する技術蓄積を活用し、3Dセンシングのメリットを享受した新たな製品やサービスを実現するための3D認識システムとして、2004年にGREEEN(Gesture Recognition Engine Environment:ジェスチャ認識エンジン環境)の開発・販売を開始した。

GREEENはその名のとおり、ジェスチャつまり人体動作の認識を主眼とした認識ソフトウェア・エンジンであり、人体およびその各部位をリアルタイムで認識し、その連続的な動きをジェスチャとして認識するものである。

距離画像センサを利用した人体の認識は、Microsoft Kinectの登場を契機としてアミューズメントを中心とした分野でメジャーとなった。

GREEENはその当初より、3D形状認識をベースとした独自の認識アルゴリズムにより、3D観測データを得られるデバイスであれば容易に対応が可能であり、また距離画像センサの解像度・設置角度など、利用シーンに関する許容範囲の広さを大きな特長としている。

これにより、車両内、製造現場、医療現場等において非接触で機器を操作するジェスチャ・ユーザ・インタフェイス、デジタルサイネージやアトラクション等で人間の自然な動きに反応するジェスチャ・インタラクション・コンテンツ、さらには介護現場やトイレといった特定の現場で被写体のプライバシーを侵害することなく危険な動作を検知するモニタリングシステム等、様々な分野でこれまでにないアプリケーションが可能となった。

さらに3Dセンシングにおける近年の動向として、特に自動車の自動運転分野を中心としたLIDAR への注目の高まりが挙げられる。現在、様々な企業によってソリッドステートなLIDARの開発が進められているが、従来はレーザーセンサを回転させるメカニカルスキャン方式のLIDARが中心であった。

一般に距離画像カメラと比較して、LIDAR の観測可能距離は長く、数 10m から数100mに及ぶが、3D認識の観点から見た場合、レーザーセンサの数に制約される解像度の粗さが問題になる。

上述のとおり、GREEENは特定のデバイスに依存しないフレームワークをもち、また比較的低い解像度においても動作が可能である。この特長を生かし、日本コントロールシステムは2013年にGREEENをVelodyne社のメカニカルスキャン方式のLIDARに対応させた。

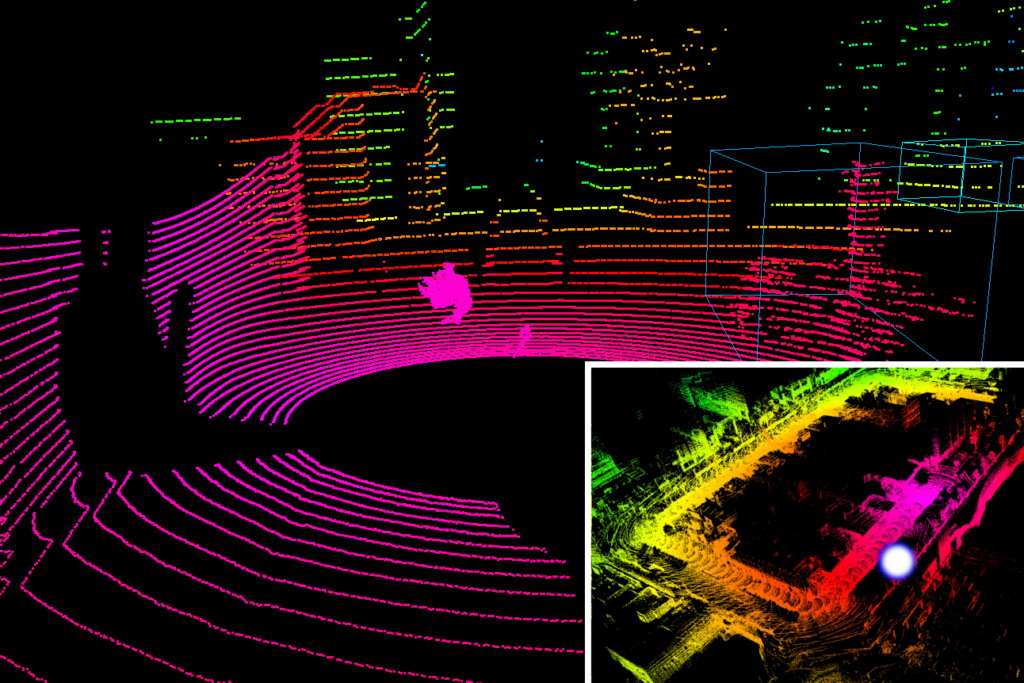

さらに2017年には、連続的な3Dデータから観測点の移動量の推定を行う自己位置認識機能を追加し(図1)、移動中の自己位置を認識しつつ、シーンの中から人・モノを検出・識別する3D認識システムとして、GREEEN×LIDARを発表した。

図1

認識対象および認識範囲が拡張されたことで、GREEEN×LIDARの適用分野は、自動運転における周辺環境認識、省人化が求められる建設現場での重機位置認識・施工状況計測、あるいは物流現場での搬送経路のトレース等、飛躍的に拡大することになった。

2.特長

GREEEN/GREEEN×LIDARは、独立性の高い複数のレイヤから構成されるフレームワークにより、特定の3Dセンシングデバイスの仕様に依存しない汎用的な3D認識システムを実現している。

距離画像センサやLIDARの分野では性能の向上、小型化、低価格化が急速に進んでいるが、測定方式、対象距離、解像度はまちまちであり、インタフェイスやプロトコルも統一されていないのが現状である。

GREEEN/GREEEN×LIDARでは、フレームワークの最下層に位置するDevice Layerの抽象化モジュール(Camera Abstraction Module)により、各種の3Dセンシングデバイスが抽象化される。

レイヤ間のインタフェイスは共通化されているため、抽象化モジュールを追加することで、固有の仕様をもつ3Dセンシングデバイスと接続し、人体等のオブジェクトの認識や自己位置の認識を行うCore Layer、人体動作の解析や3次元空間の可視化を行うUI LayerといったGREEENの機能を利用することができる(図2)。

図2

このフレームワークにより、GREEENは現在、15種類以上の距離画像センサおよびLIDARに対応しており、世界で最も多くの3Dセンシングデバイスに対応する3D認識システムの1つとなっている(図3)。

_差替え.png)

図3

またGREEEN/GREEEN×LIDARのもう1つの特長として、3D形状特徴識別や3D点群マッチングといった3D認識アルゴリズムを基盤とすることでアクティブ方式の3Dセンシングデバイスの利点を活かしつつ、移動観測に対応した幅広い認識機能をリアルタイムで実現していることが挙げられる。

TOFやアクティブステレオといったアクティブな3Dセンシング方式は、対象物のテクスチャ等による影響を受けず、また暗所でもセンシングが可能であるため、パッシブ方式と比較して環境に対してロバストな観測が可能である。

GREEEN/GREEEN×LIDARではこれらのアクティブな観測により取得できるデータのみを認識対象とすることで、環境に対する堅牢性を損なうことなく3D認識を実現している。

これは自動運転等で有用となるセンサ・フュージョンの重要な構成要素となるものである。GREEEN単独で複数の3Dセンシングデバイスを組み合わせ、統一された3D座標系におけるデータを出力する仮想的なデバイスとして認識に用いることも可能である。

また、GREEEN/GREEEN×LIDARは、3Dセンシングデバイスを搭載した観測主体そのものが移動する移動観測に対応しており、10~60fps程度のフレームレートで取得されるそれらのデータからリアルタイムなオブジェクトの認識や自己位置の認識が可能である。

このため、走行中の車輌における周辺環境の認識、あるいは即時性の高い人間の動作への反応を実現できる。

3.市場動向と応用例

前述のように、自動運転分野におけるLIDARによる周辺環境認識システムの重要性は広く認識されているところである。また建築・土木現場においてはBIM/CIMへの取り組みにより3D情報のさらなる有効活用が求められており、人手不足を解消するために省人化・無人化を支援するシステムが必要とされている。

製造現場においては、効率的な搬送とそのトレースが重要となっている。 GREEEN×LIDARはこれらのニーズに応えることを意図したものであり、現在、試作機や工場等の現場で様々な実証試験が進められている。

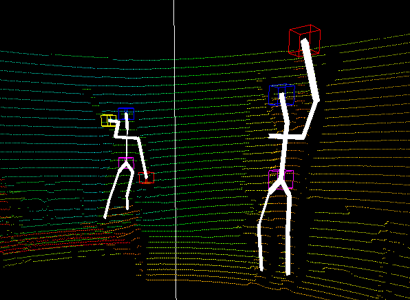

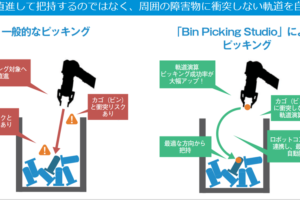

3.1 自動運転(図4)

自動車・AGV・サービスロボットなどの自動運転においては、移動中に自己の位置を認識しつつ、周辺の建造物、障害物、人間をできるだけ早期にかつリアルタイムで認識することが行動計画の策定に不可欠である。GREEEN×LIDARは、これらすべての機能を単独で同時に実現することができる。もちろん、センサ・フュージョンの構成要素として活用することも可能である。

図4

3.2 無人化施工支援(図5)

重機にGREEEN×LIDARを搭載することで、施設内や地下といったGPSの使用が困難な場所においても、自己位置を認識することができる。周辺の作業員等の検出や施工対象の寸法計測も同時に実施することができるため、無人化施工を総合的に支援することが可能である。

図5

3.3 搬送トレース(図6)

磁気テープや反射板を必要としないAGVの誘導方式として利用できるだけでなく、クレーン等のその他の搬送機器にGREEEN×LIDARを設置することで、移動経路をトレースし、運搬された貨物の場所を記録することができる。寸法や素材等の問題で管理が難しかった資材についても、必要になった時点で容易に配置を確認・把握することが可能である。

図6

4.今後の展開

3Dセンシングデバイス分野は日進月歩の段階にあり、特にLIDARについてはソリッドステートなFlash LIDARやPhased Array LIDARの開発が急ピッチで進んでいる。

また距離画像カメラについても、LIDARより相対的に高い空間解像度をそのままに、これまで課題であった外乱光耐性や最大観測距離を向上させたものが登場してきている。

GREEEN/GREEEN×LIDARでは、柔軟なフレームワークによりこれらの新たなデバイスに迅速に対応しつつ、同一の3D座標系において自己位置認識とオブジェクト認識が可能であるという長所を活かし、より総合的な3D認識システムの実現を進めている。

これにより移動観測においてよりロバストな認識を可能とし、様々な分野で適用を進めていきたい。

■問い合わせ

日本コントロールシステム株式会社

TEL:045-477-5800

http://www.nippon-control-system.co.jp/

コメントを残す